AI十級「找茬」選手,非這(zhè)個(gè)書生莫屬,節後開源!

新智元報道(dào)

編輯:好困桃子(zǐ)

爲(wéi / wèi)了(le/liǎo)測試,研發團隊的(de)大(dà)哥都爬樹上(shàng)了(le/liǎo)!什麽模型竟然隻需 10% 的(de)訓練數據,性能就(jiù)能超越同行,還會免費開源?

考驗你眼力的(de)時(shí)候到(dào)了(le/liǎo)!

隻看一(yī / yì /yí)眼,看出(chū)什麽了(le/liǎo)嘛?

一(yī / yì /yí)塊木地(dì / de)闆?

隻答對了(le/liǎo)一(yī / yì /yí)半,其實圖中還有一(yī / yì /yí)隻喵。

下一(yī / yì /yí)個(gè)問題,這(zhè)是(shì)什麽品種的(de)貓?啊...這(zhè)...

承認吧,你是(shì)辨别不(bù)出(chū)來(lái)的(de),但是(shì)這(zhè)個(gè) AI「一(yī / yì /yí)眼」就(jiù)搞定了(le/liǎo)。

而(ér)這(zhè)麽厲害的(de) AI 還有個(gè)詩意的(de)名字,叫「書生」。

更厲害的(de)是(shì),基于(yú)「書生」的(de)通用視覺開源平台 OpenGVLab 将會在(zài)春節後全部公開!

通用?視覺?

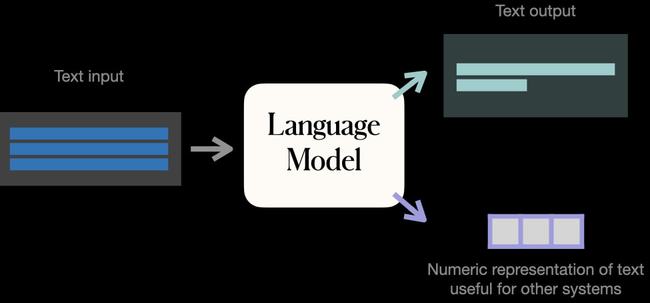

近幾年,語言模型的(de)發展可謂是(shì)相當迅猛,百花齊放。

小到(dào) 3.54 億參數的(de) BERT,大(dà)到(dào) 5300 億參數的(de)威震天-圖靈,以(yǐ)及 1.6 萬億參數的(de)混合模型 Switch Transformer,順便還有首次常識問答超越人(rén)類的(de) KEAR。

那麽,視覺模型這(zhè)邊又如何呢?

目前的(de) CV 領域主要(yào / yāo)是(shì)圖像匹配文本 CLIP 和(hé / huò)文本生成圖像 DALL·E這(zhè)種單一(yī / yì /yí)模型。

但是(shì) NLP 方向的(de)各種成績都表明,發展預訓練大(dà)模型不(bù)僅僅能夠處理多種複雜任務、适用多種場景和(hé / huò)模态,而(ér)且能夠增加模型的(de)複用率,減少了(le/liǎo)模型定制化開發的(de)開銷進而(ér)也(yě)降低了(le/liǎo)成本。

而(ér)且,通用模型也(yě)是(shì)通往通用人(rén)工智能的(de)必經之(zhī)路。

和(hé / huò)通用語言模型類似,通用視覺模型的(de)出(chū)發點和(hé / huò)訓練思路也(yě)需要(yào / yāo)事先通過收集海量的(de)無監督數據。然後通過自監督等方式來(lái)訓練,得到(dào)通用的(de)預訓練模型。最後根據具體的(de)下遊任務再将通用預訓練模型遷移到(dào)具體任務上(shàng)去解決具體問題。

不(bù)過,從任務角度看,通用視覺模型主要(yào / yāo)還是(shì)解決純視覺任務,也(yě)涉及一(yī / yì /yí)些視覺語言相關的(de)多模态任務,而(ér)通用語言模型主要(yào / yāo)在(zài)解決語言相關的(de)任務。而(ér)從模型訓練角度看,兩者的(de)模型結構存在(zài)一(yī / yì /yí)些差異,具體訓練的(de)監督形式也(yě)不(bù)一(yī / yì /yí)樣。

但是(shì)想要(yào / yāo)實現模型的(de)通用性,很難。

首當其沖的(de)就(jiù)是(shì),訓練數據不(bù)夠用。

訓練一(yī / yì /yí)個(gè)性能合格的(de)深度學習模型,所需的(de)數據采集量,少則十幾萬,多則千百萬張圖片,比如自動駕駛和(hé / huò)人(rén)臉識别,對于(yú)數據的(de)需求,達到(dào)十億級别,但性能仍未飽和(hé / huò)。

在(zài)現實應用中,AI 需要(yào / yāo)大(dà)量業務數據和(hé / huò)用戶互聯網行爲(wéi / wèi)數據的(de)融合,而(ér)企業可以(yǐ)應用的(de)數據則非常有限。

數據都采集不(bù)到(dào),就(jiù)更不(bù)用提什麽「高質量」了(le/liǎo)。

此外,模型對于(yú)數據的(de)學習效率又低,無疑又是(shì)雪上(shàng)加霜。

于(yú)是(shì),N個(gè)任務就(jiù)需要(yào / yāo)開發N個(gè)高度定制的(de)模型同時(shí),每個(gè)模型在(zài)訓練的(de)時(shí)候又需構建标注數據集進行專項訓練,并持續進行權重和(hé / huò)參數優化。

時(shí)間、人(rén)力以(yǐ)及資源的(de)成本直接拉滿。

即便如此,依然有人(rén)想要(yào / yāo)挑戰一(yī / yì /yí)番。

2021 年 11 月,上(shàng)海人(rén)工智能實驗室聯合商湯科技 SenseTime、香港中文大(dà)學、上(shàng)海交通大(dà)學共同發布了(le/liǎo)新一(yī / yì /yí)代通用視覺技術體系——「書生」(INTERN)。

論文地(dì / de)址:https://arxiv.org/abs/2111.08687

通才是(shì)如何練成?

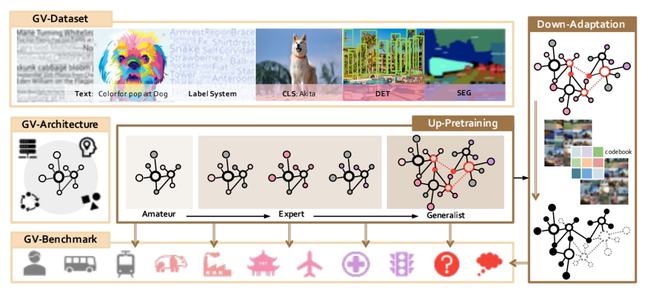

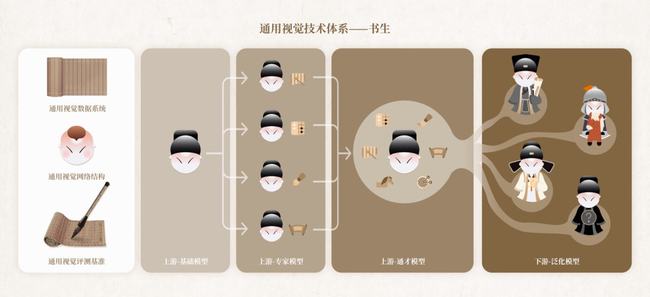

作爲(wéi / wèi)通用視覺技術體系的(de)「書生」有三個(gè)基礎設施模塊,分别爲(wéi / wèi):

通用視覺數據系統(GV-Dataset)

通用視覺網絡結構(GV-Architecture)

通用視覺評測基準(GV-Benchmark)

這(zhè)三個(gè)基礎模塊有什麽作用?

它們就(jiù)像「百科全書」、「高樓基底」一(yī / yì /yí)樣。「書生」通才的(de)道(dào)路上(shàng)學到(dào)的(de)海量知識和(hé / huò)建模、評測等基礎能力就(jiù)靠這(zhè)三個(gè)基礎模塊了(le/liǎo)。

具體點講,其中,在(zài)通用視覺數據系統中包含了(le/liǎo)大(dà)量的(de)高質量數據集:

1. 超大(dà)量級精标注數據:除了(le/liǎo)整合現有開源數據集,還進行了(le/liǎo)大(dà)規模數據圖像标注任務,涵蓋了(le/liǎo)圖像分類,目标檢測以(yǐ)及圖像分割等任務,數據總量級達到(dào) 40M。

分類任務數據量級爲(wéi / wèi) 71M,其中包含 9 個(gè)公開數據集 28M,以(yǐ)及自标注數據 43M。目标檢測任務數據量級爲(wéi / wèi) 4M,其中包含 3 個(gè)公開數據集 3M,以(yǐ)及自标注數據 1M。

2. 超大(dà)标簽體系:總标簽量級達到(dào) 119K,幾乎覆蓋了(le/liǎo)所有現有開源數據集,在(zài)此基礎上(shàng)擴充了(le/liǎo)大(dà)量細粒度标簽。

極大(dà)地(dì / de)豐富了(le/liǎo)圖像任務的(de)标簽,提供了(le/liǎo)更爲(wéi / wèi)合理的(de)組織方式,以(yǐ)及可擴展的(de)标簽延伸策略。

3. 首次提出(chū)視界(realm)概念:結合「書生」标簽體系,可以(yǐ)極大(dà)提升預訓練模型的(de)性能。

在(zài)通用視覺網絡結構中,MetaNet 是(shì)一(yī / yì /yí)種自研的(de)模型搜索網絡,它最大(dà)的(de)變種包含百億的(de)參數量,是(shì)當今最大(dà)的(de)視覺網絡之(zhī)一(yī / yì /yí)。

這(zhè)個(gè)網絡結構結合了(le/liǎo)視覺卷積和(hé / huò)前沿的(de)視覺自關注機制,通過大(dà)規模強化學習網絡結構搜索算法,取得最佳算子(zǐ)組合,達到(dào)模型效率和(hé / huò)效用的(de)最大(dà)化。

在(zài)相同的(de)資源限制的(de)情況下,「書生」的(de)視覺網絡獲得在(zài)不(bù)同視覺任務下更優異的(de)精度。

在(zài)獲得超大(dà)規模的(de)視覺神經網絡以(yǐ)賦能計算機視覺社區的(de)研究的(de)同時(shí),「書生」的(de)網絡支持靈活地(dì / de)進行不(bù)同規模的(de)調整,以(yǐ)适應不(bù)同程度的(de)工業化落地(dì / de)時(shí)的(de)運算能力需求,賦能視覺算法的(de)工業落地(dì / de)。

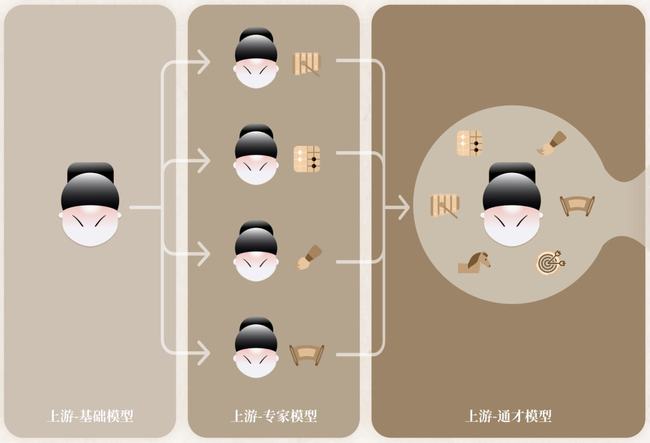

有了(le/liǎo)這(zhè)樣的(de)網絡結構之(zhī)後,就(jiù)可以(yǐ)對其進行了(le/liǎo)從「基礎模型-專家-通才」模型的(de)訓練策略,極大(dà)地(dì / de)增強這(zhè)種網絡結構的(de)泛化能力。

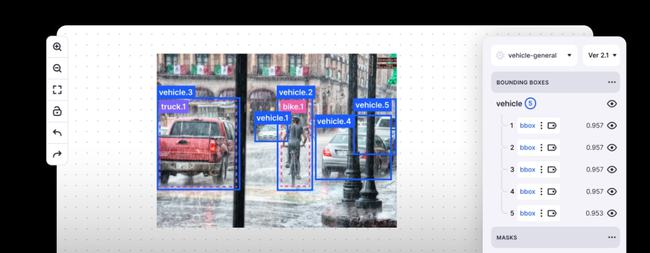

第三個(gè)便是(shì)視覺評測基準,它就(jiù)像是(shì)一(yī / yì /yí)個(gè)「擂台」,收集了(le/liǎo) 4 種類型共 26 個(gè)下遊任務。

不(bù)僅包括常規分類任務還包括細粒度分類任務,還包括醫療圖像等特殊領域的(de)分類任務、行人(rén)檢測等熱門檢測任務,擴展到(dào)分割與深度任務,可以(yǐ)很好地(dì / de)衡量模型的(de)泛化能力。

這(zhè)一(yī / yì /yí)視覺評測基準還引入了(le/liǎo)百分比樣本(percentage-shot)的(de)設置。

亮點在(zài)于(yú),下遊任務訓練數據被壓縮的(de)同時(shí),還可以(yǐ)很好地(dì / de)保留原始數據集的(de)長尾分布等屬性。

「書生」除了(le/liǎo)這(zhè)三個(gè)基礎設施模塊之(zhī)外,還有四個(gè)訓練階段模塊。

在(zài)「書生」(INTERN)的(de)四個(gè)訓練階段中,前三個(gè)階段位于(yú)該技術鏈條的(de)上(shàng)遊,在(zài)模型的(de)表征通用性上(shàng)發力。

第一(yī / yì /yí)階段,「基礎能力」的(de)培養需要(yào / yāo)經過一(yī / yì /yí)個(gè)跨模态的(de)預訓練過程,通過大(dà)量的(de)圖像-文本對進行通用模型的(de)預訓練,讓其學到(dào)廣泛的(de)基礎常識,爲(wéi / wèi)後續學習階段打好基礎;

第二階段,培養「專家能力」,即多個(gè)專家模型各自學習某一(yī / yì /yí)領域的(de)專業知識,讓每一(yī / yì /yí)個(gè)專家模型高度掌握該領域技能,成爲(wéi / wèi)專家;

第三階段,培養「通用能力」,此時(shí)的(de)通才模型繼承了(le/liǎo)大(dà)規模多模态的(de)預訓練信息,也(yě)融合了(le/liǎo)多樣的(de)感知任務的(de)信息,「書生」在(zài)各個(gè)技能領域都展現優異水平,并具備快速學會新技能的(de)能力。

通過前三個(gè)模塊階梯式的(de)學習,「書生」具備了(le/liǎo)高度的(de)通用性和(hé / huò)良好的(de)泛化能力。

當進化到(dào)位于(yú)下遊的(de)第四階段時(shí),系統将具備「遷移能力」,此時(shí)「書生」學到(dào)的(de)通用知識可以(yǐ)應用在(zài)某一(yī / yì /yí)個(gè)特定領域的(de)不(bù)同任務中。

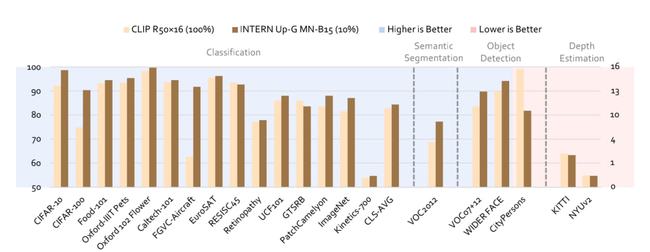

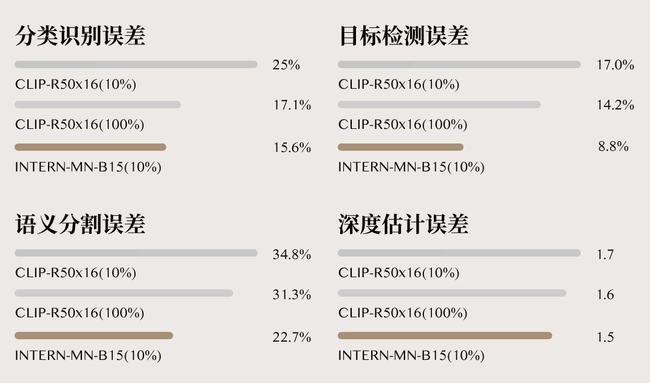

從實驗結果來(lái)看,相較于(yú)當前最強 CV 模型 CLIP,「書生」在(zài)準确率和(hé / huò)數據使用效率上(shàng)均取得了(le/liǎo)大(dà)幅提升。

具體來(lái)講,在(zài)分類識别、目标檢測、語義分割及深度估計四大(dà)任務 26 個(gè)數據集上(shàng),「書生」的(de)平均錯誤率分别降低了(le/liǎo) 40.2%、47.3%、34.8% 和(hé / huò) 9.4%。

同時(shí),「書生」隻需要(yào / yāo)1/10 的(de)下遊數據,就(jiù)幹翻了(le/liǎo) CLIP 基于(yú)完整下遊數據的(de)準确度。

書生不(bù)是(shì)「書呆子(zǐ)」

光學不(bù)去練,不(bù)會用,還是(shì)沒啥本事。

要(yào / yāo)明确的(de)是(shì),商湯的(de)「書生」可不(bù)是(shì)一(yī / yì /yí)個(gè)書呆子(zǐ)。

怎麽講?

首先,它能夠舉一(yī / yì /yí)反三。

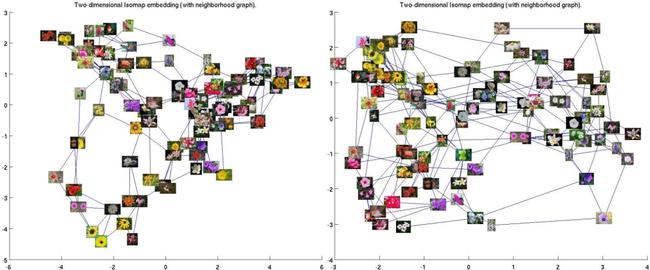

舉個(gè)形象點的(de)栗子(zǐ),比如讓「書生」識别花的(de)種類,每一(yī / yì /yí)類隻需要(yào / yāo)提供 2 個(gè)訓練樣本,識别準确率高達 99.7%。

這(zhè)個(gè)花卉數據集由 102 種英國(guó)常見的(de)花組成,每個(gè)類别有 40 至 258 張圖片。其中包含有很大(dà)的(de)比例、姿勢和(hé / huò)光線變化。

它不(bù)僅有觸類旁通的(de)能力,而(ér)且在(zài)自動駕駛、智慧城市、智慧醫療等場景均已經實現了(le/liǎo)落地(dì / de)應用。

就(jiù)拿自動駕駛來(lái)說(shuō)吧,要(yào / yāo)想不(bù)成爲(wéi / wèi)馬路殺手,一(yī / yì /yí)套 CV 模型需要(yào / yāo)能夠識别各種物體,包括交通标志,車道(dào)線識别等,還得預測出(chū)與障礙物的(de)距離,行人(rén)檢測等等。

對于(yú)這(zhè)些任務,單一(yī / yì /yí)視覺模型是(shì)無法勝任的(de)。

而(ér)「書生」技術體系從數據、模型等各個(gè)方面出(chū)發,對自動駕駛感知模型,尤其是(shì)長尾類别和(hé / huò)場景非常友好,在(zài)小樣本甚至是(shì)零樣本的(de)應用場景下表現明顯優于(yú)既往模型。

其實,在(zài)實際場景應用中,數據都存在(zài)長尾分布的(de)現象,少量類别占據大(dà)多數樣本,而(ér)大(dà)量類别僅有少量樣本。

在(zài)智慧城市中也(yě)是(shì)同樣的(de)道(dào)理,面對很多長尾、碎片化場景就(jiù)不(bù)得不(bù)祭出(chū)通才「書生」了(le/liǎo)。

生活中,我們經常會見到(dào)城市街道(dào)上(shàng)的(de)井蓋頻頻丢失的(de)問題。

如果 CV 模型沒有關注城市治理的(de)長尾問題,偷井蓋問題很難得到(dào)解決。況且,井蓋也(yě)有很多種樣子(zǐ)。

但是(shì),這(zhè)對于(yú)通才「書生」來(lái)講都是(shì)小 case。隻要(yào / yāo)每一(yī / yì /yí)類提供 2 個(gè)訓練樣本,問題不(bù)就(jiù)搞定了(le/liǎo)嗎。

因爲(wéi / wèi)它已經在(zài)訓練階段被「喂下」大(dà)量數據成爲(wéi / wèi)通才,隻需要(yào / yāo)看到(dào)少量樣本,就(jiù)具備了(le/liǎo)舉一(yī / yì /yí)反三的(de)能力。

有了(le/liǎo)「書生」的(de)加持,不(bù)僅可以(yǐ)預防井蓋丢失,還能實現事後追責的(de)精細化管理。

此外,智慧制造、智慧醫療等應用中還會存在(zài)很多類似的(de)長尾場景,而(ér)通用視覺「書生」的(de)推出(chū)能夠讓業界以(yǐ)更低的(de)成本獲得擁有處理多種下遊任務能力的(de) AI 模型。

并以(yǐ)其強大(dà)的(de)泛化能力支撐實際場景中大(dà)量小數據、零數據等樣本缺失的(de)細分和(hé / huò)長尾場景需求。

書生(INTERN)技術體系可以(yǐ)讓 AI 模型處理多樣化的(de)視覺任務

這(zhè)些暴力計算下的(de) AI 場景需要(yào / yāo)強大(dà)的(de)算力作爲(wéi / wèi)支撐,這(zhè)時(shí)候 SenseCore 商湯 AI 大(dà)裝置正好就(jiù)派上(shàng)用場了(le/liǎo)。

AI 大(dà)裝置正是(shì)通過超強的(de)算力基礎,爲(wéi / wèi)人(rén)工智能的(de)研發、創新和(hé / huò)應用提供源動力。

正如商湯科技研究院院長王曉剛所提到(dào)的(de)那樣:

「書生」通用視覺技術體系是(shì)商湯在(zài)通用智能技術發展趨勢下前瞻性布局的(de)一(yī / yì /yí)次嘗試,也(yě)是(shì) SenseCore 商湯 AI 大(dà)裝置背景下的(de)一(yī / yì /yí)次新技術路徑探索。 「書生」承載了(le/liǎo)讓人(rén)工智能參與處理多種複雜任務、适用多種場景和(hé / huò)模态、有效進行小數據和(hé / huò)非監督學習并最終具備接近人(rén)的(de)通用視覺智能的(de)期盼。 希望這(zhè)套技術體系能夠幫助業界更好地(dì / de)探索和(hé / huò)應用通用視覺 AI 技術,促進 AI 規模化落地(dì / de)。

不(bù)過,想要(yào / yāo)成爲(wéi / wèi)一(yī / yì /yí)個(gè)優秀的(de)通用視覺模型,「書生」還有三個(gè)挑戰需要(yào / yāo)解決:

1. 模型優化速度的(de)提升

對于(yú)一(yī / yì /yí)個(gè)好的(de)預訓練模型,往往需要(yào / yāo)更大(dà)更好的(de)網絡結構,以(yǐ)及大(dà)規模的(de)數據,這(zhè)就(jiù)會導緻幾天甚至幾周的(de)模型訓練時(shí)間,如何在(zài)保持表征能力的(de)同時(shí),大(dà)幅度加速模型的(de)訓練過程,具有非常重大(dà)的(de)現實意義。

2. 更大(dà)範圍内的(de)通用能力仍待探索

書生模型,可以(yǐ)很好地(dì / de)在(zài)常見的(de)視覺任務裏達到(dào)通用的(de)效果。在(zài)跨度較大(dà)的(de)領域,比如超分等底層視覺任務,書生模型還有很大(dà)的(de)進步空間。

3. 大(dà)模型到(dào)小模型的(de)轉變

将大(dà)模型的(de)表征能力無損失的(de)遷移到(dào)可部署到(dào)終端設備上(shàng)的(de)小模型,對于(yú)預訓練模型的(de)推廣有非常大(dà)的(de)價值。

One More Thing

要(yào / yāo)問這(zhè)個(gè)模型好不(bù)好做?

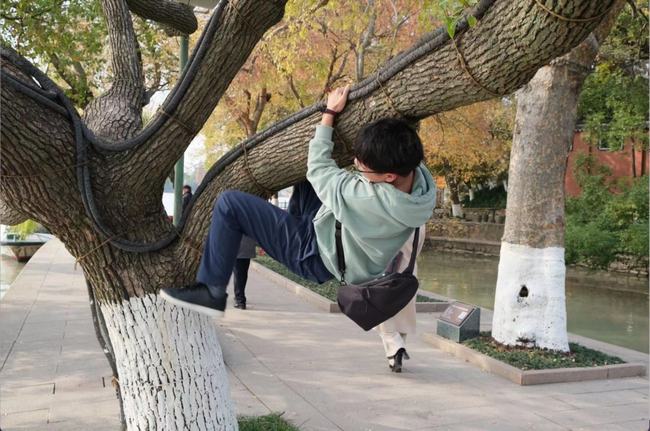

研發急得都直「爬樹」!

爲(wéi / wèi)了(le/liǎo)測試模型在(zài) zero-shot 下的(de)精度如何,書生研發團隊的(de)模型科學家都親自上(shàng)演了(le/liǎo)「爬樹」特别節目。通過創造特殊場景,以(yǐ)随機生成圖片,去考驗模型能力。

(研究需要(yào / yāo),大(dà)家請勿模仿^_^)

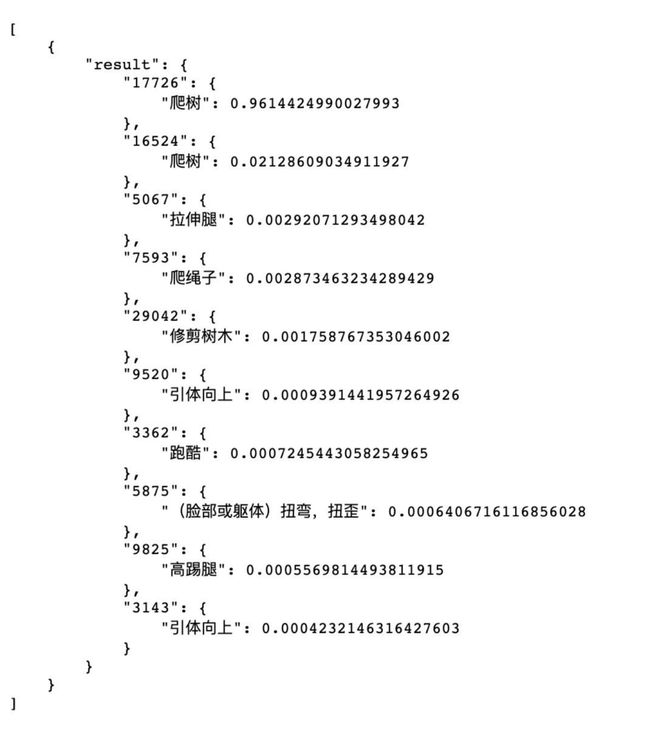

「書生」看到(dào)後,歪嘴一(yī / yì /yí)笑。

這(zhè)不(bù)就(jiù)是(shì)「爬樹」嘛,置信度 0.96 給你。

而(ér)且有趣的(de)是(shì),「書生」模型還注意到(dào)了(le/liǎo)樹上(shàng)人(rén)眼都很容易忽略的(de)繩子(zǐ)。

可能,這(zhè)就(jiù)是(shì)「明察秋毫」吧!

未來(lái),「書生」要(yào / yāo)做的(de)一(yī / yì /yí)件事情:

基于(yú)「書生」的(de)通用視覺開源平台 OpenGVLab 也(yě)将在(zài)今年年初正式開源,産學研一(yī / yì /yí)道(dào)共創通用 AI 生态!

而(ér)即将開源的(de) OpenGVLab,正是(shì)基于(yú)「書生」的(de)通用視覺開源平台。

其中的(de)網絡結構除了(le/liǎo)商湯自研的(de) MetaNet,還包含大(dà)家普遍使用的(de) ResNet, MobileNet, ViT, EfficientNet 等,以(yǐ)滿足不(bù)同場景的(de)應用,賦能計算機視覺。

然而(ér),「書生」的(de)布局不(bù)止于(yú)此。

OpenGVLab 将與上(shàng)海人(rén)工智能實驗室此前發布的(de) OpenMMLab、OpenDILab 一(yī / yì /yí)道(dào),共同構築開源體系 OpenXLab,持續推進通用人(rén)工智能的(de)技術突破和(hé / huò)生态構建。

「書生」研發團隊的(de)一(yī / yì /yí)位成員調侃道(dào),「随着書生模型精度越來(lái)越高,我們的(de)辦公樓層越來(lái)越高。」

開源的(de)「書生」,前景廣闊。